Deepfake và video call: Lợi dụng công nghệ để lừa đảo

Cập nhật ngày: 30-03-2023

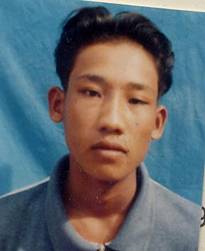

Nhận được cuộc gọi, nghe được giọng nói và thấy được hình ảnh qua video call của người thân, tuy nhiên một số người vẫn bị lừa chuyển khoản mất tiền, vì đó là do công nghệ, chứ không phải là người thật.

.jpg)

Nhận được cuộc gọi, nghe được giọng nói và thấy được hình ảnh qua video call

của người thân, tuy nhiên một số người vẫn bị lừa chuyển khoản mất tiền

Hiện tại, công nghệ AI, đặc biệt là Deepfake, ngoài phục vụ mục đích hỗ trợ con người rất nhiều trong cuộc sống, thì nó cũng là công cụ để một số thành phần sử dụng với mục đích xấu, như lừa đảo, giả mạo, bôi nhọ, thậm chí làm tin giả dạng video.

* Deepfake là gì?

Deepfake là thuật ngữ ghép từ chữ deep-learning nghĩa là học sâu và fake là giả. Deep-learning là hướng nghiên cứu trong AI, giúp máy tư duy giống người một cách sâu sắc hơn. Công nghệ deepfake sẽ thu thập hình ảnh khuôn mặt của một đối tượng, sau đó thay thế khuôn mặt này vào mặt của một người khác trong video. Đối với các tập tin âm thanh, deepfake sử dụng bản ghi âm giọng nói của một người thực để huấn luyện máy tính nói chuyện giống hệt người ấy.

* Deepfake dùng để làm gì?

Nói chung, deepfake dùng để tạo ra những đoạn video giả dựa trên những dữ liệu thật: nội dung video là thật, nhưng hình ảnh và tiếng nói của nhân vật trong video là giả.

Trong ví dụ trên, deepfake là công cụ giải trí thú vị nhưng nó còn có nhiều công dụng lớn hơn. Tùy theo mục đích, video tạo bằng deepfake có thể có ích hoặc có hại.

Mục đích tốt: Ví dụ như một MC trên TV do bị bệnh mà mất giọng tạm thời, dùng deepfake để tạm thời thay thế MC ấy trong thời gian bệnh. Hoặc một bộ phim thực hiện sắp xong nhưng chẳng may một diễn viên qua đời, deepfake sẽ tạo hình diễn viên ấy để thực hiện phần còn lại của bộ phim.

Hay trong các video mang tính giáo dục, deepfake có thể dùng để tạo hình và tiếng cho một số nhân vật lịch sử dựa theo hình ảnh và giọng nói còn lưu lại để minh họa được sinh động hơn.

Mục đích xấu: Điều đáng tiếc là hiện nay deepfake được sử dụng cho mục đích xấu khá nhiều. Hai trong số những mục đích xấu tiêu biểu được sử dụng nhiều nhất hiện nay là tuyên truyền sai lệch về chính trị và bôi nhọ bằng phim ảnh khiêu dâm.

Người ta có thể tạo video deepfake bôi xấu đối thủ chính trị của mình, như mô tả ứng cử viên tổng thống đang quấy rối trẻ em, hoặc một cảnh sát trưởng đang xúi giục nhân viên thực hiện hành vi bạo lực với người dân tộc thiểu số…

Việc dùng deepfake để ghép mặt nhân vật nữ vào những video khiêu dâm, khỏa thân sẽ gây ảnh hưởng xấu đến danh dự và phẩm giá của họ. Những video này có đặc điểm là lan truyền rất nhanh cho dù không phân biệt thật giả.

Tại sao Deepfake có thể giả giọng, mặt người thân để lừa đảo?

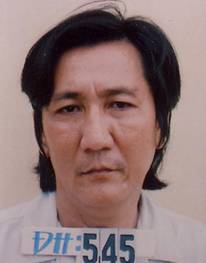

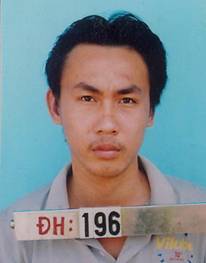

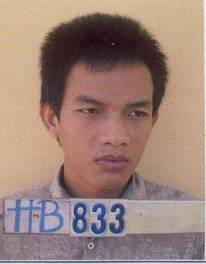

Nắm bắt được tâm lý người dùng mạng xã hội hiện cảnh giác với chiêu trò lừa đảo bằng tin nhắn nhờ chuyển tiền, các đối tượng đã sử dụng chiêu lừa đảo tinh vi hơn để vay tiền thông qua hình thức giả cuộc gọi video.

Thủ đoạn của các đối tượng lừa đảo là lấy những video cũ của người dùng, cắt ghép hoặc dùng công nghệ deepfake để khi thực hiện hành vi lừa đảo sẽ phát lại video dưới hình thức mờ ảo, chập chờn như đang ở nơi sóng yếu.

Theo các chuyên gia về công nghệ, phương thức của các đối tượng này thường là tìm kiếm thu thập thông tin cá nhân được đăng tải công khai trên các tài khoản mạng xã hội… để tạo ra một kịch bản lừa đảo. Khi nạn nhân cẩn thận sẽ gọi điện thoại hoặc video để kiểm tra thì chúng sử dụng phần mềm cắt ghép hình ảnh để đánh lừa.

Cơ quan chức năng nhiều lần đưa ra cảnh báo với người dân cần đặc biệt cảnh giác với thủ đoạn lừa đảo tinh vi này. Khi có ai đó đề nghị mượn tiền, người dân cần thận trọng xác minh xem đó có phải là bạn bè, người thân của mình hay không.

Gần đây, các nạn nhân bị lừa đảo bằng các hình thức giả danh Facebook, hack Facebook để lừa tiền ngày càng có xu hướng gia tăng trên khắp cả nước. Các đối tượng lừa đảo dùng thủ đoạn rất tinh vi, có thể xảy ra với bất cứ ai và bất cứ thời điểm nào. Các đối tượng lừa đảo gọi cuộc gọi video call để giả làm người thân vay tiền, giả làm con cái đang du học nước ngoài gọi điện cho bố mẹ nhờ chuyển tiền đóng học phí hay có thể giả làm nhân vật nào đó khi kết bạn hẹn hò qua mạng để phục vụ cho các kịch bản chúng chuẩn bị sẵn.

Công an các địa phương liên tục đưa ra những khuyến cáo với người dân, khi nhận bất kỳ tin nhắn vay mượn tiền thông qua mạng xã hội, người dân cần điện thoại trực tiếp cho người thân để xác minh. Trường hợp nghi vấn đối tượng giả mạo người thân trên mạng xã hội để lừa đảo, chiếm đoạt tài sản, cần báo ngay cho cơ quan công an gần nhất để được hỗ trợ, xử lý kịp thời.

.jpg)

Cảnh báo hình thức lừa đảo bằng Deepfake để giả giọng, mặt người thân

Làm gì để dữ liệu khuôn mặt và giọng nói không bị lợi dụng cho Deepfake?

Cách tốt nhất để tránh bị làm giả Deepfake, người sử dụng nên hạn chế chia sẻ hình ảnh hay video cá nhân lên trên mạng; đồng thời luôn bảo mật tài khoản mạng xã hội, email bằng mật khẩu có độ khó cao.

Nếu bị làm giả Deepfake, người sử dụng nên thông báo ngay lập tức cho mọi người biết và báo cơ quan chức năng tại địa chỉ canhbao.ncsc.gov.vn hoặc báo lên dự án chongluadao https://chongluadao.vn; đồng thời cần nâng cao nhận thức về nhận biết lừa đảo trên không gian mạng tại: dauhieuluadao.com.

Nếu chia sẻ video hay clip trên mạng nên làm méo tiếng của mình, thay bằng tiếng robot hoặc AI voice, để tránh kẻ xấu biết giọng nói thật của mình./.

Hải Phương

Các tin khác

-

Untitled Document -

-

-

Đang online: 1 Hôm nay: 6534 Trong tuần: 47700 Trong tháng 109828 Tất cả: 17203382